Термин в теории информации

В теории информации , информационное измерение является информационной мерой для случайных векторов в евклидовом пространстве , на основе нормированной энтропии тонко квантованных версий случайных векторов . Эта концепция была впервые представлена Альфредом Реньи в 1959 году.

Проще говоря, это мера фрактальной размерности в виде распределения вероятностей . Он характеризует скорость роста энтропии Шеннона, задаваемую последовательно более тонкой дискретизацией пространства.

В 2010 году Ву и Верду дали рабочую характеристику информационного измерения Реньи как фундаментального предела сжатия данных практически без потерь для аналоговых источников при различных ограничениях регулярности кодера / декодера.

Определение и свойства

Энтропия дискретной случайной величины равна

где - мера вероятности того, когда , а обозначает набор .

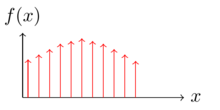

Позвольте быть произвольной действительной случайной величиной. Учитывая положительное целое число , мы создаем новую дискретную случайную величину

где - оператор пола, который преобразует действительное число в наибольшее целое меньшее его. потом

а также

называются нижним и верхним информационными измерениями соответственно. Когда мы называем это ценностным информационным измерением ,

Некоторые важные свойства информационного измерения :

- Если мягкое условие выполнено, то у нас есть .

- Для -мерного случайного вектора первое свойство можно обобщить на .

- При ограничении экспоненциальной подпоследовательностью достаточно вычислить верхнюю и нижнюю информационные размерности .

-

и остаются неизменными, если при квантовании используются функции округления или ограничения.

и остаются неизменными, если при квантовании используются функции округления или ограничения.

-Мерная энтропия

-Мерная энтропия

Если существует информационное измерение , можно определить -мерную энтропию этого распределения как

при условии, что лимит существует. Если , нульмерная энтропия равна стандартной энтропии Шеннона . Для целого размерности , то -мерная энтропия является -кратно интегралом , определяющий соответствующим дифференциал энтропии .

Дискретно-непрерывное распределение смеси

Согласно теореме Лебега о разложении , распределение вероятностей может быть однозначно представлено смесью

где и ; является чисто атомарной вероятностной мерой (дискретная часть), является абсолютно непрерывной вероятностной мерой и является вероятностной мерой, сингулярной по отношению к мере Лебега, но без атомов (сингулярная часть). Позвольте быть случайной величиной, такой что . Предположим, что распределение можно представить как

где - дискретная мера, - абсолютно непрерывная вероятностная мера с . потом

Кроме того, учитывая и дифференциальную энтропию , то -мерная энтропия просто задаются

где это Шеннон энтропия дискретной случайной величины с и и задаются

Пример

Рассмотрим сигнал с гауссовым распределением вероятностей .

Мы пропускаем сигнал через полуволновой выпрямитель, который преобразует все отрицательные значения в 0 и поддерживает все остальные значения. Однополупериодный выпрямитель можно охарактеризовать функцией

Тогда на выходе выпрямителя сигнал имеет выпрямленное гауссово распределение . Он характеризуется атомной массой 0,5 и имеет гауссову PDF для всех .

С этим смешанным распределением мы применяем приведенную выше формулу и получаем информационную размерность распределения и вычисляем -мерную энтропию.

Нормализованная правая часть гауссова распределения с нулевым средним имеет энтропию , следовательно,

Связь с дифференциальной энтропией

Показано, что информационная размерность и дифференциальная энтропия тесно связаны.

Позвольте быть случайной величиной с непрерывной плотностью .

Предположим, мы делим диапазон на интервалы длины . По теореме о среднем значении в каждой ячейке существует такое значение , что

Рассмотрим дискретизированную случайную величину, если .

Вероятность каждой точки поддержки равна

Пусть . Энтропия IS

Если мы установили, а затем мы делаем точно такое же квантование, что и определение информационного измерения. Поскольку перемаркировка событий дискретной случайной величины не изменяет ее энтропию, мы имеем

Это дает

а когда достаточно большой,

которая является дифференциальной энтропией непрерывной случайной величины. В частности, если она интегрируема по Риману, то

Сравнение этой энтропии с -мерной энтропией показывает, что дифференциальная энтропия - это в точности одномерная энтропия

Фактически, это можно обобщить на более высокие измерения. Реньи показывает, что если - случайный вектор в -мерном евклидовом пространстве с абсолютно непрерывным распределением с функцией плотности вероятности и конечной энтропией целой части ( ), то имеем

а также

если интеграл существует.

Сжатие данных без потерь

Информационное измерение распределения дает теоретическую верхнюю границу степени сжатия, если кто-то хочет сжать переменную, полученную из этого распределения. В контексте сжатия данных без потерь мы пытаемся сжать действительное число с меньшим количеством действительного числа, оба из которых имеют бесконечную точность.

Основная цель сжатия данных без потерь - найти эффективные представления для исходных реализаций с помощью . Код представляет собой пару отображений:

- кодировщик: который преобразует информацию из источника в символы для передачи или хранения;

- декодер: обратный процесс преобразования кодовых символов обратно в форму, понятную получателю.

Вероятность ошибки блока составляет .

Определить быть инфимумом из таких , что существует последовательность кодов , таких , что для всех достаточно больших .

Таким образом, в основном дает соотношение между длиной кода и длиной источника, это показывает, насколько хороша конкретная пара кодеров-декодеров. Основные ограничения в кодировании источников без потерь заключаются в следующем.

Рассмотрим функцию непрерывного кодирования с ее функцией непрерывного декодирования . Если мы не налагаем регулярности и , благодаря богатой структуре , у нас будет минимально- достижимая ставка для всех . Это означает, что можно построить пару кодер-декодер с бесконечной степенью сжатия.

Чтобы получить какие-то нетривиальные и содержательные выводы, приведем минимально достижимую скорость для линейного кодера и декодера Бореля. Если случайная величина имеет распределение, которое представляет собой смесь дискретной и непрерывной частей. Тогда для всех. Предположим, мы ограничиваем декодер до липшицевой функции и выполняется, тогда минимально достижимая скорость для всех .

Смотрите также

Примечания

использованная литература