Тип искусственной нейронной сети, использующей радиальные базисные функции в качестве функций активации.

В области математического моделирования , A радиальной базисной функции сети является искусственной нейронной сети , которая использует радиальные базисные функции , как функции активации . Выход сети представляет собой линейную комбинацию радиальных базисных функций входов и параметров нейрона. Сети радиальных базисных функций имеют множество применений, включая аппроксимацию функций , прогнозирование временных рядов , классификацию и управление системой . Впервые они были сформулированы в статье 1988 года Брумхедом и Лоу, исследователями из Royal Signals and Radar Establishment .

Сетевая архитектура

Архитектура сети радиальных базисных функций. Входной вектор используется в качестве входных данных для всех радиальных базисных функций, каждая из которых имеет разные параметры. Выход сети представляет собой линейную комбинацию выходов радиальных базисных функций.

Сети с радиальной базисной функцией (RBF) обычно имеют три уровня: входной уровень, скрытый уровень с нелинейной функцией активации RBF и линейный выходной слой. Вход можно смоделировать как вектор действительных чисел . Выход сети тогда является скалярной функцией входного вектора , и определяется выражением

где - количество нейронов в скрытом слое, - центральный вектор нейрона и - вес нейрона в линейном выходном нейроне. Функции, которые зависят только от расстояния от центрального вектора, радиально симметричны относительно этого вектора, отсюда и название радиальная базисная функция. В базовой форме все входы подключены к каждому скрытому нейрону. Норма , как правило , принимается за евклидово расстояния (хотя расстояние Махаланобиса по- видимому, лучше выполнить с распознаванием образами) и радиальная базисная функция обычно берутся гауссовским

-

![{\ displaystyle \ rho {\ big (} \ left \ Vert \ mathbf {x} - \ mathbf {c} _ {i} \ right \ Vert {\ big)} = \ exp \ left [- \ beta _ {i } \ left \ Vert \ mathbf {x} - \ mathbf {c} _ {i} \ right \ Vert ^ {2} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/810b210447cf6a4e00b141425a5da1cf6cb3914c) .

.

Базисные функции Гаусса локальны по отношению к центральному вектору в том смысле, что

т.е. изменение параметров одного нейрона имеет лишь небольшой эффект для входных значений, которые находятся далеко от центра этого нейрона.

При определенных мягких условиях на форму функции активации RBF-сети являются универсальными аппроксиматорами на компактном подмножестве . Это означает, что RBF-сеть с достаточным количеством скрытых нейронов может аппроксимировать любую непрерывную функцию на замкнутом ограниченном множестве с произвольной точностью.

Параметры , и определяются таким образом, чтобы оптимизировать соответствие между данными и.

Нормализованный

Две нормированные радиальные базисные функции в одном входном измерении (

сигмоиды ). Базовые функциональные центры расположены в и .

Три нормализованных радиальных базисных функции в одном входном измерении. Дополнительная базовая функция имеет центр в

Четыре нормализованных радиальных базисных функции в одном входном измерении. Четвертая базисная функция имеет центр в . Обратите внимание, что первая базовая функция (темно-синий) стала локализованной.

Нормализованная архитектура

В дополнение к вышеупомянутой ненормализованной архитектуре, сети RBF могут быть нормализованы . В этом случае отображение

где

называется нормализованной радиальной базисной функцией .

Теоретическая мотивация нормализации

Есть теоретическое обоснование этой архитектуры в случае стохастического потока данных. Предположим стохастическое ядерное приближение для совместной плотности вероятности

где веса и являются примерами из данных, и мы требуем, чтобы ядра были нормализованы

а также

-

.

.

Плотности вероятностей во входном и выходном пространствах равны

а также

Математическое ожидание y при вводе равно

где

условная вероятность данного y . Условная вероятность связана с совместной вероятностью через теорему Байеса.

который дает

-

.

.

Это становится

когда выполняются интеграции.

Локальные линейные модели

Иногда удобно расширить архитектуру, включив в нее локальные линейные модели. В этом случае архитектуры становятся, в первую очередь,

а также

в ненормализованном и нормализованном случаях соответственно. Вот веса, которые предстоит определить. Возможны также линейные члены более высокого порядка.

Этот результат можно записать

где

![e _ {{ij}} = {\ begin {cases} a_ {i}, & {\ mbox {if}} i \ in [1, N] \\ b _ {{ij}}, & {\ mbox {if} } i \ in [N + 1,2N] \ end {case}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e69e7a0b20246396ad4ecf0619932d3818cb14fb)

а также

![v _ {{ij}} {\ big (} {\ mathbf {x}} - {\ mathbf {c}} _ {i} {\ big)} \ {\ stackrel {{\ mathrm {def}}} {= }} \ {\ begin {cases} \ delta _ {{ij}} \ rho {\ big (} \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}, & {\ mbox {if}} i \ in [1, N] \\\ left (x _ {{ij}} - c _ {{ij}} \ right) \ rho {\ big ( } \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}, & {\ mbox {if}} i \ in [N + 1, 2N] \ end {case}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6194ed23e27bf63b899a072ce2803f31fba1f84)

в ненормализованном случае и

![v _ {{ij}} {\ big (} {\ mathbf {x}} - {\ mathbf {c}} _ {i} {\ big)} \ {\ stackrel {{\ mathrm {def}}} {= }} \ {\ begin {cases} \ delta _ {{ij}} u {\ big (} \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}, & {\ mbox {if}} i \ in [1, N] \\\ left (x _ {{ij}} - c _ {{ij}} \ right) u {\ big (} \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}, & {\ mbox {if}} i \ in [N + 1,2N] \ end {case}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0f7d20e63f94b312d972d1c925a999de68c68735)

в нормализованном случае.

Вот является функция Кронекера определяется как

-

.

.

Обучение

Сети RBF , как правило , обучены с парами входных и выходных значений , с помощью алгоритма двухступенчатого.

На первом этапе выбираются центральные векторы функций RBF в скрытом слое. Этот шаг можно выполнить несколькими способами; центры могут быть отобраны случайным образом из некоторого набора примеров, или они могут быть определены с помощью кластеризации k-средних . Обратите внимание, что этот шаг выполняется без присмотра .

Второй шаг просто подбирает линейную модель с коэффициентами для выходов скрытого слоя по отношению к некоторой целевой функции. Общей целевой функцией, по крайней мере, для оценки регрессии / функции, является функция наименьших квадратов:

где

-

![K_ {t} ({\ mathbf {w}}) \ {\ stackrel {{\ mathrm {def}}} {=}} \ {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} ^ {2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/47c25fbbbb15c069216597e2a3489f0c7ba6ac62) .

.

Мы явно включили зависимость от весов. Минимизация целевой функции наименьших квадратов за счет оптимального выбора весов оптимизирует точность подбора.

Бывают случаи, когда необходимо оптимизировать несколько целей, таких как плавность и точность. В этом случае полезно оптимизировать регуляризованную целевую функцию, такую как

где

а также

где оптимизация S максимизирует гладкость и известна как параметр регуляризации .

Третий необязательный шаг обратного распространения может быть выполнен для точной настройки всех параметров сети RBF.

Интерполяция

RBF сети могут быть использованы для интерполяции функции , когда значения этой функции известны на конечном числе точек: . Принимая известные точки за центры радиальных базисных функций и оценивая значения базисных функций в тех же точках, веса могут быть решены из уравнения

![\ left [{\ begin {matrix} g _ {{11}} & g _ {{12}} & \ cdots & g _ {{1N}} \\ g _ {{21}} & g _ {{22}} & \ cdots & g _ {{ 2N}} \\\ vdots && \ ddots & \ vdots \\ g _ {{N1}} & g _ {{N2}} & \ cdots & g _ {{NN}} \ end {matrix}} \ right] \ left [{\ begin {matrix} w_ {1} \\ w_ {2} \\\ vdots \\ w_ {N} \ end {matrix}} \ right] = \ left [{\ begin {matrix} b_ {1} \\ b_ {2} \\\ vdots \\ b_ {N} \ end {matrix}} \ right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/9a4456b5dd861c3af9665875ed2e674003029074)

Можно показать, что матрица интерполяции в приведенном выше уравнении неособая, если точки различны, и, таким образом, веса могут быть решены с помощью простой линейной алгебры:

где .

Аппроксимация функции

Если целью является не выполнение строгой интерполяции, а вместо этого более общее приближение или классификация функций, оптимизация несколько сложнее, потому что нет очевидного выбора для центров. Тренировка обычно проводится в два этапа: сначала фиксируются ширина и центры, а затем веса. Это может быть оправдано, если рассмотреть различную природу нелинейных скрытых нейронов по сравнению с линейным выходным нейроном.

Обучение базовых функциональных центров

Центры базисных функций могут быть случайным образом отобраны среди входных экземпляров или получены с помощью алгоритма обучения методом наименьших квадратов, либо найдены путем кластеризации выборок и выбора кластерных средних в качестве центров.

Ширина RBF обычно фиксируется на одном и том же значении, которое пропорционально максимальному расстоянию между выбранными центрами.

Псевдообратное решение для линейных весов

После фиксации центров веса, которые минимизируют ошибку на выходе, могут быть вычислены с помощью линейного псевдообратного решения:

-

,

,

где элементы матрицы G являются значения радиальных базисных функций оцененных в точках : .

Существование этого линейного решения означает, что в отличие от многослойных сетей персептронов (MLP), сети RBF имеют явный минимизатор (когда центры фиксированы).

Тренировка линейных весов градиентным спуском

Другой возможный алгоритм обучения - градиентный спуск . При обучении градиентному спуску веса корректируются на каждом временном шаге, перемещая их в направлении, противоположном градиенту целевой функции (что позволяет найти минимум целевой функции),

где - «параметр обучения».

Для случая обучения линейных весов алгоритм принимает вид

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} \ rho {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d6ff0ca244dbf79403808304d1970f20cee63383)

в ненормализованном случае и

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} u {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Верт {\ big)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/30d53a925c043711f42e74be811973f9c14563ea)

в нормализованном случае.

Для локальной линейно-линейной архитектуры обучение градиентному спуску

![e _ {{ij}} (t + 1) = e _ {{ij}} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t ), {\ mathbf {w}} {\ big)} {\ big]} v _ {{ij}} {\ big (} {\ mathbf {x}} (t) - {\ mathbf {c}} _ { i} {\ big)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6ed23c9f1311d7090b1f9354acd1ea651133e87b)

Обучение оператора проекции линейных весов

Для случая обучения линейных весов и алгоритм принимает вид

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {\ rho {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ { i} \ right \ Vert {\ big)}} {\ sum _ {{i = 1}} ^ {N} \ rho ^ {2} {\ big (} \ left \ Vert {\ mathbf {x}} ( t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/daada7fa66c0c152fa6ddbe9b4688bab0e069771)

в ненормализованном случае и

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {u {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i } \ right \ Vert {\ big)}} {\ sum _ {{i = 1}} ^ {N} u ^ {2} {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ded07d14fa15e102334231468d90bc62d88fba0e)

в нормированном случае и

![e _ {{ij}} (t + 1) = e _ {{ij}} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t ), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {v _ {{ij}} {\ big (} {\ mathbf {x}} (t) - {\ mathbf {c }} _ {i} {\ big)}} {\ sum _ {{i = 1}} ^ {N} \ sum _ {{j = 1}} ^ {n} v _ {{ij}} ^ {2 } {\ big (} {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ca63b9d8b8402fb255847feee9f93cbedcfd71bd)

в локально-линейном случае.

Для одной базовой функции обучение оператора проекции сводится к методу Ньютона .

Рисунок 6: Временные ряды логистической карты. Повторяющаяся итерация логистической карты порождает хаотический временной ряд. Значения лежат между нулем и единицей. Здесь показаны 100 тренировочных точек, использованных для обучения примерам из этого раздела. Веса c являются первыми пятью точками этого временного ряда.

Примеры

Логистическая карта

Основные свойства радиальных базисных функций можно проиллюстрировать с помощью простой математической карты, логистической карты , которая отображает единичный интервал на себя. Его можно использовать для создания удобного потока данных прототипа. Логистическая карта может использоваться для изучения приближения функций , прогнозирования временных рядов и теории управления . Карта возникла из области динамики численности населения и стала прототипом хаотических временных рядов. Карта в полностью хаотическом режиме имеет вид

![x (t + 1) \ {\ stackrel {{\ mathrm {def}}} {=}} \ f \ left [x (t) \ right] = 4x (t) \ left [1-x (t) \ верно]](https://wikimedia.org/api/rest_v1/media/math/render/svg/d18e751a88c7fd2ac285b21f9c567db55c214e97)

где t - временной индекс. Значение x в момент времени t + 1 является параболической функцией x в момент времени t. Это уравнение представляет собой базовую геометрию хаотического временного ряда, созданного логистической картой.

Генерация временных рядов из этого уравнения - прямая задача . Примеры здесь иллюстрируют обратную задачу ; идентификация основной динамики или фундаментального уравнения логистической карты по образцам временного ряда. Цель - найти оценку

![x (t + 1) = f \ left [x (t) \ right] \ приблизительно \ varphi (t) = \ varphi \ left [x (t) \ right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/db59ba99d8c9e0d2e5d34cae9692a5f3a22cf33b)

для f.

Аппроксимация функции

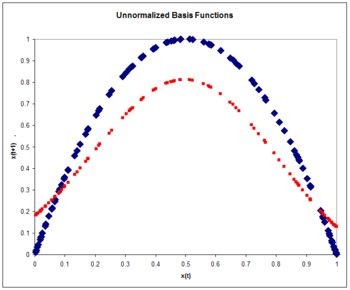

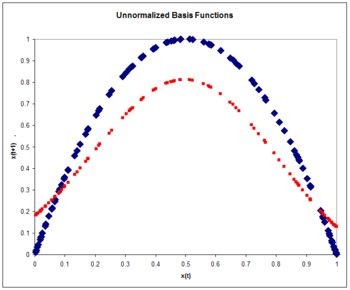

Ненормализованные радиальные базисные функции

Архитектура

Рисунок 7: Ненормализованные базисные функции. Логистическая карта (синий) и приближение к логистической карте (красный) после одного прохода через обучающую выборку.

где

-

![{\ displaystyle \ rho {\ big (} \ left \ Vert \ mathbf {x} - \ mathbf {c} _ {i} \ right \ Vert {\ big)} = \ exp \ left [- \ beta _ {i } \ left \ Vert \ mathbf {x} - \ mathbf {c} _ {i} \ right \ Vert ^ {2} \ right] = \ exp \ left [- \ beta _ {i} \ left (x (t ) -c_ {i} \ right) ^ {2} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25c7d4d37abe3b8601a437cb4769cddc6cf3833e) .

.

Поскольку входные данные являются скаляром, а не вектором , размерность входных данных равна единице. Мы выбираем количество базисных функций как N = 5, а размер обучающей выборки - 100 экземпляров, сгенерированных хаотическим временным рядом. Вес взят постоянным, равным 5. Веса - это пять экземпляров из временного ряда. Гири обучаются с обучением оператора проецирования:

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} x (t + 1) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {\ rho {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}} {\ sum _ {{i = 1}} ^ {N} \ rho ^ {2} {\ big (} \ left \ Vert {\ mathbf {x} } (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d4fce40bfbe9b946581809f2a627f174aaf33c64)

где скорость обучения принята равной 0,3. Тренировка проводится с одним проходом через 100 тренировочных точек. Квадратичная ошибка равна 0,15.

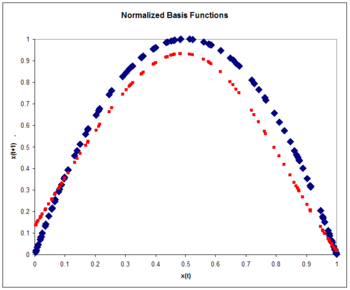

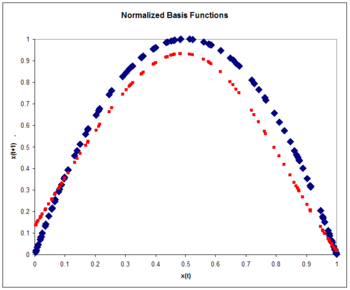

Рисунок 8: Нормализованные базисные функции. Логистическая карта (синий) и приближение к логистической карте (красный) после одного прохода через обучающую выборку. Обратите внимание на улучшение по сравнению с ненормализованным случаем.

Нормализованные радиальные базисные функции

Нормализованная архитектура RBF

где

-

.

.

Очередной раз:

-

![\ rho {\ big (} \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)} = \ exp \ left [- \ beta \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert ^ {2} \ right] = \ exp \ left [- \ beta \ left (x (t) -c_ {i} \ right) ^ {2} \ right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/b386dbd43b5eb5df76b52f6e6214f2b4339d4dae) .

.

Опять же, мы выбираем количество базовых функций, равное пяти, и размер обучающего набора, равный 100 образцам, сгенерированным хаотическим временным рядом. Вес взят постоянным, равным 6. Веса - это пять экземпляров из временного ряда. Гири обучаются с обучением оператора проецирования:

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} x (t + 1) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {u {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}} {\ sum _ {{i = 1}} ^ {N} u ^ {2} {\ big (} \ left \ Vert {\ mathbf {x}} ( t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be34ccc983222e1bbeb72d63eab95e64393dceb0)

где скорость обучения снова принята равной 0,3. Тренировка проводится с одним проходом через 100 тренировочных точек. Квадратичная ошибка на тестовом наборе 100 экземпляров является 0,084, меньше ненормированного ошибки. Нормализация дает повышение точности. Обычно точность с нормализованными базисными функциями увеличивается еще больше по сравнению с ненормализованными функциями по мере увеличения входной размерности.

Рисунок 9: Нормализованные базисные функции. Логистическая карта (синий) и приближение к логистической карте (красный) как функция времени. Обратите внимание, что приближение подходит только для нескольких временных шагов. Это общая характеристика хаотических временных рядов.

Прогнозирование временных рядов

После того, как базовая геометрия временного ряда оценена, как в предыдущих примерах, прогноз для временного ряда может быть сделан путем итерации:

-

![{x} (t + 1) \ приблизительно \ varphi (t) = \ varphi [\ varphi (t-1)]](https://wikimedia.org/api/rest_v1/media/math/render/svg/8ebe0e8d1ef472dc874ee8861bb9968afe83ad5a) .

.

На рисунке показано сравнение фактического и расчетного временных рядов. Расчетный временной ряд начинается в нулевой момент времени с точным знанием x (0). Затем он использует оценку динамики для обновления оценки временного ряда для нескольких временных шагов.

Обратите внимание, что оценка точна только для нескольких временных шагов. Это общая характеристика хаотических временных рядов. Это свойство чувствительной зависимости от начальных условий, характерных для хаотических временных рядов. Небольшая начальная ошибка со временем усиливается. Мера расхождения временных рядов с почти одинаковыми начальными условиями известна как показатель Ляпунова .

Контроль хаотического временного ряда

Рисунок 10: Управление логистической картой. Системе позволено естественным образом развиваться за 49 временных шагов. В момент времени 50 включается управление. Желаемая траектория для временного ряда отмечена красным. Управляемая система изучает основную динамику и приводит временной ряд к желаемому результату. Архитектура такая же, как и в примере прогнозирования временных рядов.

Мы предполагаем, что выходными данными логистической карты можно управлять с помощью управляющего параметра , так что

![c [x (t), t]](https://wikimedia.org/api/rest_v1/media/math/render/svg/a43de76171d5e934b86617d2c4f31173f85f1943)

-

![{x} _ {{}} ^ {{}} (t + 1) = 4x (t) [1-x (t)] + c [x (t), t]](https://wikimedia.org/api/rest_v1/media/math/render/svg/ff5cb6dda1ba3c7e3514d4472f64c4b2cd1ab18f) .

.

Цель состоит в том, чтобы выбрать параметр управления таким образом, чтобы привести временной ряд к желаемому результату . Это можно сделать, если мы выберем управляющий параметр равным

![c _ {{}} ^ {{}} [x (t), t] \ {\ stackrel {{\ mathrm {def}}} {=}} \ - \ varphi [x (t)] + d (t + 1)](https://wikimedia.org/api/rest_v1/media/math/render/svg/e75069785f599ea18ae354ac38e34f625816011a)

где

![y [x (t)] \ приблизительно f [x (t)] = x (t + 1) -c [x (t), t]](https://wikimedia.org/api/rest_v1/media/math/render/svg/398cd41f2ca68133f79c5f62a81068049fca98b8)

является приближением к основной естественной динамике системы.

Алгоритм обучения представлен

где

-

![\ varepsilon \ {\ stackrel {{\ mathrm {def}}} {=}} \ f [x (t)] - \ varphi [x (t)] = x (t + 1) -c [x (t) , t] - \ varphi [x (t)] = x (t + 1) -d (t + 1)](https://wikimedia.org/api/rest_v1/media/math/render/svg/6acad5ff76bdcad25bf1beb62674724290392c10) .

.

Смотрите также

Рекомендации

дальнейшее чтение

- J. Moody и CJ Darken, "Быстрое обучение в сетях локально настроенных процессоров", Neural Computation, 1, 281-294 (1989). См. Также Радиальные сети базисных функций согласно Moody и Darken.

- T. Poggio и F. Girosi, " Сети для приближения и обучения ", Proc. IEEE 78 (9), 1484-1487 (1990).

-

Роджер Д. Джонс , YC Lee, CW Barnes, GW Flake, K. Lee, PS Lewis и S. Qian,? Функция приближения и прогнозирования временных рядов с нейронными сетями ,? Труды Международной совместной конференции по нейронным сетям, 17–21 июня, с. И-649 (1990).

-

Мартин Д. Бухманн (2003). Радиальные базисные функции: теория и реализации . Кембриджский университет. ISBN 0-521-63338-9.

-

Йи, Пол В. и Хайкин, Саймон (2001). Регуляризованные сети с радиальными базисными функциями: теория и приложения . Джон Вили. ISBN 0-471-35349-3.

- Джон Р. Дэвис, Стивен В. Коггесхолл, Роджер Д. Джонс и Дэниел Шутцер, «Интеллектуальные системы безопасности», в книге Фридмана, Роя С., Флейна, Роберта А. и Ледермана, Джесс, редакторов (1995). Искусственный интеллект на рынках капитала . Чикаго: Ирвин. ISBN 1-55738-811-3.CS1 maint: несколько имен: список авторов ( ссылка )

-

Саймон Хайкин (1999). Нейронные сети: всеобъемлющий фундамент (2-е изд.). Река Аппер Сэдл, штат Нью-Джерси: Prentice Hall. ISBN 0-13-908385-5.

- С. Чен, CFN Cowan и PM Grant, " Алгоритм обучения ортогональным наименьшим квадратам для сетей с радиальными базисными функциями ", IEEE Transactions on Neural Networks, Vol 2, No. 2 (Mar) 1991.

![{\ displaystyle \ rho {\ big (} \ left \ Vert \ mathbf {x} - \ mathbf {c} _ {i} \ right \ Vert {\ big)} = \ exp \ left [- \ beta _ {i } \ left \ Vert \ mathbf {x} - \ mathbf {c} _ {i} \ right \ Vert ^ {2} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/810b210447cf6a4e00b141425a5da1cf6cb3914c)

![e _ {{ij}} = {\ begin {cases} a_ {i}, & {\ mbox {if}} i \ in [1, N] \\ b _ {{ij}}, & {\ mbox {if} } i \ in [N + 1,2N] \ end {case}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e69e7a0b20246396ad4ecf0619932d3818cb14fb)

![v _ {{ij}} {\ big (} {\ mathbf {x}} - {\ mathbf {c}} _ {i} {\ big)} \ {\ stackrel {{\ mathrm {def}}} {= }} \ {\ begin {cases} \ delta _ {{ij}} \ rho {\ big (} \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}, & {\ mbox {if}} i \ in [1, N] \\\ left (x _ {{ij}} - c _ {{ij}} \ right) \ rho {\ big ( } \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}, & {\ mbox {if}} i \ in [N + 1, 2N] \ end {case}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6194ed23e27bf63b899a072ce2803f31fba1f84)

![v _ {{ij}} {\ big (} {\ mathbf {x}} - {\ mathbf {c}} _ {i} {\ big)} \ {\ stackrel {{\ mathrm {def}}} {= }} \ {\ begin {cases} \ delta _ {{ij}} u {\ big (} \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}, & {\ mbox {if}} i \ in [1, N] \\\ left (x _ {{ij}} - c _ {{ij}} \ right) u {\ big (} \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}, & {\ mbox {if}} i \ in [N + 1,2N] \ end {case}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0f7d20e63f94b312d972d1c925a999de68c68735)

![K_ {t} ({\ mathbf {w}}) \ {\ stackrel {{\ mathrm {def}}} {=}} \ {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} ^ {2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/47c25fbbbb15c069216597e2a3489f0c7ba6ac62)

![\ left [{\ begin {matrix} g _ {{11}} & g _ {{12}} & \ cdots & g _ {{1N}} \\ g _ {{21}} & g _ {{22}} & \ cdots & g _ {{ 2N}} \\\ vdots && \ ddots & \ vdots \\ g _ {{N1}} & g _ {{N2}} & \ cdots & g _ {{NN}} \ end {matrix}} \ right] \ left [{\ begin {matrix} w_ {1} \\ w_ {2} \\\ vdots \\ w_ {N} \ end {matrix}} \ right] = \ left [{\ begin {matrix} b_ {1} \\ b_ {2} \\\ vdots \\ b_ {N} \ end {matrix}} \ right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/9a4456b5dd861c3af9665875ed2e674003029074)

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} \ rho {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d6ff0ca244dbf79403808304d1970f20cee63383)

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} u {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Верт {\ big)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/30d53a925c043711f42e74be811973f9c14563ea)

![e _ {{ij}} (t + 1) = e _ {{ij}} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t ), {\ mathbf {w}} {\ big)} {\ big]} v _ {{ij}} {\ big (} {\ mathbf {x}} (t) - {\ mathbf {c}} _ { i} {\ big)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6ed23c9f1311d7090b1f9354acd1ea651133e87b)

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {\ rho {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ { i} \ right \ Vert {\ big)}} {\ sum _ {{i = 1}} ^ {N} \ rho ^ {2} {\ big (} \ left \ Vert {\ mathbf {x}} ( t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/daada7fa66c0c152fa6ddbe9b4688bab0e069771)

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {u {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i } \ right \ Vert {\ big)}} {\ sum _ {{i = 1}} ^ {N} u ^ {2} {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ded07d14fa15e102334231468d90bc62d88fba0e)

![e _ {{ij}} (t + 1) = e _ {{ij}} (t) + \ nu {\ big [} y (t) - \ varphi {\ big (} {\ mathbf {x}} (t ), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {v _ {{ij}} {\ big (} {\ mathbf {x}} (t) - {\ mathbf {c }} _ {i} {\ big)}} {\ sum _ {{i = 1}} ^ {N} \ sum _ {{j = 1}} ^ {n} v _ {{ij}} ^ {2 } {\ big (} {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ca63b9d8b8402fb255847feee9f93cbedcfd71bd)

![x (t + 1) \ {\ stackrel {{\ mathrm {def}}} {=}} \ f \ left [x (t) \ right] = 4x (t) \ left [1-x (t) \ верно]](https://wikimedia.org/api/rest_v1/media/math/render/svg/d18e751a88c7fd2ac285b21f9c567db55c214e97)

![x (t + 1) = f \ left [x (t) \ right] \ приблизительно \ varphi (t) = \ varphi \ left [x (t) \ right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/db59ba99d8c9e0d2e5d34cae9692a5f3a22cf33b)

![{\ displaystyle \ rho {\ big (} \ left \ Vert \ mathbf {x} - \ mathbf {c} _ {i} \ right \ Vert {\ big)} = \ exp \ left [- \ beta _ {i } \ left \ Vert \ mathbf {x} - \ mathbf {c} _ {i} \ right \ Vert ^ {2} \ right] = \ exp \ left [- \ beta _ {i} \ left (x (t ) -c_ {i} \ right) ^ {2} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25c7d4d37abe3b8601a437cb4769cddc6cf3833e)

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} x (t + 1) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {\ rho {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}} {\ sum _ {{i = 1}} ^ {N} \ rho ^ {2} {\ big (} \ left \ Vert {\ mathbf {x} } (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d4fce40bfbe9b946581809f2a627f174aaf33c64)

![\ rho {\ big (} \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)} = \ exp \ left [- \ beta \ left \ Vert {\ mathbf {x}} - {\ mathbf {c}} _ {i} \ right \ Vert ^ {2} \ right] = \ exp \ left [- \ beta \ left (x (t) -c_ {i} \ right) ^ {2} \ right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/b386dbd43b5eb5df76b52f6e6214f2b4339d4dae)

![a_ {i} (t + 1) = a_ {i} (t) + \ nu {\ big [} x (t + 1) - \ varphi {\ big (} {\ mathbf {x}} (t), {\ mathbf {w}} {\ big)} {\ big]} {\ frac {u {\ big (} \ left \ Vert {\ mathbf {x}} (t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}} {\ sum _ {{i = 1}} ^ {N} u ^ {2} {\ big (} \ left \ Vert {\ mathbf {x}} ( t) - {\ mathbf {c}} _ {i} \ right \ Vert {\ big)}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be34ccc983222e1bbeb72d63eab95e64393dceb0)

![{x} (t + 1) \ приблизительно \ varphi (t) = \ varphi [\ varphi (t-1)]](https://wikimedia.org/api/rest_v1/media/math/render/svg/8ebe0e8d1ef472dc874ee8861bb9968afe83ad5a)

![c [x (t), t]](https://wikimedia.org/api/rest_v1/media/math/render/svg/a43de76171d5e934b86617d2c4f31173f85f1943)

![{x} _ {{}} ^ {{}} (t + 1) = 4x (t) [1-x (t)] + c [x (t), t]](https://wikimedia.org/api/rest_v1/media/math/render/svg/ff5cb6dda1ba3c7e3514d4472f64c4b2cd1ab18f)

![c _ {{}} ^ {{}} [x (t), t] \ {\ stackrel {{\ mathrm {def}}} {=}} \ - \ varphi [x (t)] + d (t + 1)](https://wikimedia.org/api/rest_v1/media/math/render/svg/e75069785f599ea18ae354ac38e34f625816011a)

![y [x (t)] \ приблизительно f [x (t)] = x (t + 1) -c [x (t), t]](https://wikimedia.org/api/rest_v1/media/math/render/svg/398cd41f2ca68133f79c5f62a81068049fca98b8)

![\ varepsilon \ {\ stackrel {{\ mathrm {def}}} {=}} \ f [x (t)] - \ varphi [x (t)] = x (t + 1) -c [x (t) , t] - \ varphi [x (t)] = x (t + 1) -d (t + 1)](https://wikimedia.org/api/rest_v1/media/math/render/svg/6acad5ff76bdcad25bf1beb62674724290392c10)