Линейный дискриминантный анализ - Linear discriminant analysis

Линейный дискриминантный анализ ( LDA ), нормальный дискриминантный анализ ( NDA ) или анализ дискриминантной функции - это обобщение линейного дискриминанта Фишера , метода, используемого в статистике и других областях, для поиска линейной комбинации функций, которая характеризует или разделяет два или более классов. объектов или событий. Полученная комбинация может использоваться в качестве линейного классификатора или, чаще, для уменьшения размерности перед последующей классификацией .

LDA тесно связана с дисперсионным анализом (ANOVA) и регрессионным анализом , которые также пытаются выразить одну зависимую переменную как линейную комбинацию других функций или измерений. Однако ANOVA использует категориальные независимые переменные и непрерывную зависимую переменную , тогда как дискриминантный анализ имеет непрерывные независимые переменные и категориальную зависимую переменную ( т. Е. Метку класса). Логистическая регрессия и пробит-регрессия больше похожи на LDA, чем на ANOVA, поскольку они также объясняют категориальную переменную значениями непрерывных независимых переменных. Эти другие методы предпочтительны в приложениях, где неразумно предполагать, что независимые переменные имеют нормальное распределение, что является фундаментальным предположением метода LDA.

LDA также тесно связана с анализом главных компонентов (PCA) и факторным анализом, поскольку оба они ищут линейные комбинации переменных, которые лучше всего объясняют данные. LDA явно пытается смоделировать разницу между классами данных. PCA, напротив, не принимает во внимание различие в классе, а факторный анализ строит комбинации признаков на основе различий, а не сходства. Дискриминантный анализ также отличается от факторного анализа тем, что он не является методом взаимозависимости: необходимо проводить различие между независимыми переменными и зависимыми переменными (также называемыми критериальными переменными).

LDA работает, когда измерения независимых переменных для каждого наблюдения являются непрерывными величинами. При работе с категориальными независимыми переменными эквивалентным методом является дискриминантный анализ соответствия.

Дискриминантный анализ используется, когда группы известны априори (в отличие от кластерного анализа ). Каждый случай должен иметь балл по одному или нескольким количественным прогнозирующим показателям и балл по групповому показателю. Проще говоря, анализ дискриминантной функции - это классификация - акт распределения вещей на группы, классы или категории одного типа.

История

Первоначальный дихотомический дискриминантный анализ был разработан сэром Рональдом Фишером в 1936 году. Он отличается от ANOVA или MANOVA , которые используются для предсказания одной (ANOVA) или нескольких (MANOVA) непрерывно зависимых переменных с помощью одной или нескольких независимых категориальных переменных. Анализ дискриминантной функции полезен для определения того, эффективен ли набор переменных для прогнозирования принадлежности к категории.

LDA для двух классов

Рассмотрим набор наблюдений (также называемых функциями, атрибутами, переменными или измерениями) для каждой выборки объекта или события с известным классом . Этот набор образцов называется обучающим набором . Тогда задача классификации состоит в том, чтобы найти хороший предиктор для класса любой выборки того же распределения (не обязательно из обучающей выборки) с учетом только наблюдения .

LDA подходит к проблеме, предполагая, что условные функции плотности вероятности и являются нормальным распределением со средним значением и параметрами ковариации и , соответственно. При этом предположении оптимальное решение Байеса состоит в том, чтобы прогнозировать точки как принадлежащие ко второму классу, если логарифм отношений правдоподобия больше некоторого порогового значения T, так что:

Без каких-либо дополнительных предположений полученный классификатор называется QDA ( квадратичный дискриминантный анализ ).

Вместо этого LDA делает дополнительное упрощающее предположение о гомоскедастичности ( т. Е. Что ковариации классов идентичны ) и что ковариации имеют полный ранг. В этом случае отменяются несколько сроков:

- потому что это Эрмитова

и вышеупомянутый критерий решения становится порогом для скалярного произведения

для некоторой пороговой константы c , где

Это означает, что критерий принадлежности входа к классу является чисто функцией этой линейной комбинации известных наблюдений.

Часто бывает полезно увидеть этот вывод в геометрических терминах: критерий принадлежности входа к классу является чисто функцией проекции точки многомерного пространства на вектор (таким образом, мы рассматриваем только его направление). Другими словами, наблюдение принадлежит, если соответствующее находится на некоторой стороне гиперплоскости, перпендикулярной к . Расположение самолета определяется порогом c.

Предположения

Допущения дискриминантного анализа такие же, как и для MANOVA. Анализ довольно чувствителен к выбросам, и размер самой маленькой группы должен быть больше, чем количество переменных-предикторов.

- Многомерная нормальность : независимые переменные являются нормальными для каждого уровня группирующей переменной.

- Однородность дисперсии / ковариации ( гомоскедастичность ): Вариации между групповыми переменными одинаковы на разных уровнях предикторов. Можно проверить с помощью статистики М. Бокса . Однако было предложено использовать линейный дискриминантный анализ, когда ковариации равны, и что квадратичный дискриминантный анализ может использоваться, когда ковариации не равны.

- Мультиколлинеарность : предсказательная сила может уменьшаться с увеличением корреляции между предсказывающими переменными.

- Независимость : предполагается, что участники отбираются случайным образом, и предполагается, что оценка участника по одной переменной не зависит от оценок по этой переменной для всех других участников.

Было высказано предположение, что дискриминантный анализ относительно устойчив к незначительным нарушениям этих предположений, а также было показано, что дискриминантный анализ может быть надежным при использовании дихотомических переменных (где многомерная нормальность часто нарушается).

Дискриминантные функции

Дискриминантный анализ работает путем создания одной или нескольких линейных комбинаций предикторов, создавая новую скрытую переменную для каждой функции. Эти функции называются дискриминантными функциями. Количество возможных функций равно где = количество групп или (количество предикторов), в зависимости от того, что меньше. Первая созданная функция максимизирует различия между группами по этой функции. Вторая функция максимизирует различия в этой функции, но также не должна коррелировать с предыдущей функцией. Это продолжается с последующими функциями с требованием, чтобы новая функция не коррелировала ни с одной из предыдущих функций.

Для данной группы с наборами выборочного пространства существует такое дискриминантное правило, что если , то . Затем дискриминантный анализ находит «хорошие» области, чтобы минимизировать ошибку классификации, что приводит к высокому проценту правильных классификаций в таблице классификации.

Каждой функции присваивается дискриминантная оценка, чтобы определить, насколько хорошо она предсказывает размещение группы.

- Коэффициенты корреляции структуры: корреляция между каждым предиктором и дискриминантной оценкой каждой функции. Это корреляция нулевого порядка (т. Е. Не скорректированная для других предикторов).

- Стандартизированные коэффициенты: вес каждого предиктора в линейной комбинации, которая является дискриминантной функцией. Как и в уравнении регрессии, эти коэффициенты являются частичными (то есть с поправкой на другие предикторы). Указывает уникальный вклад каждого предиктора в прогнозирование группового назначения.

- Функции в центроидах группы: средние дискриминантные оценки для каждой группирующей переменной даны для каждой функции. Чем дальше друг от друга находятся средние значения, тем меньше будет ошибок в классификации.

Правила дискриминации

- Максимальная вероятность : присваивает x группе, которая максимизирует плотность населения (группы).

- Дискриминантное правило Байеса: присваивает x группе, которая максимизирует , где π i представляет априорную вероятность этой классификации и представляет плотность населения.

- Линейный дискриминантный правило Фишера : максимизирует соотношение между SS между и СС в пределах , и находит в виде линейной комбинации предикторов предсказать группу.

Собственные значения

Собственное значение в дискриминантном анализе является характеристическим корнем каждой функции. Это показатель того, насколько хорошо эта функция различает группы: чем больше собственное значение, тем лучше дифференцируется функция. Однако это следует интерпретировать с осторожностью, поскольку собственные значения не имеют верхнего предела. Собственное значение можно рассматривать как отношение SS между и SS внутри, как в ANOVA, когда зависимая переменная является дискриминантной функцией, а группы - уровнями IV . Это означает, что наибольшее собственное значение связано с первой функцией, второе по величине - со второй и т. Д.

Размер эффекта

Некоторые предлагают использовать собственные значения в качестве меры величины эффекта , однако, как правило, это не поддерживается. Вместо этого каноническая корреляция является предпочтительной мерой величины эффекта. Оно похоже на собственное значение, но представляет собой квадратный корень из отношения SS между и SS total . Это взаимосвязь между группами и функцией. Еще одна популярная мера величины эффекта - это процент отклонения для каждой функции. Это вычисляется по формуле : ( λ x / Σλ i ) X 100, где λ x - собственное значение функции, а Σ λ i - сумма всех собственных значений. Это говорит нам, насколько надежен прогноз для этой конкретной функции по сравнению с другими. Правильно классифицированный процент также может быть проанализирован как величина эффекта. Значение каппа может описать это с поправкой на случайное совпадение. Каппа нормализуется по всем категориям, а не подвергается предвзятости из-за значительно хороших или плохо выполняемых классов.

Канонический дискриминантный анализ для k классов

Канонический дискриминантный анализ (CDA) находит оси ( k - 1 канонические координаты , k - количество классов), которые лучше всего разделяют категории. Эти линейные функции не коррелированы и, по сути, определяют оптимальное k - 1 пространство через n- мерное облако данных, которое наилучшим образом разделяет (проекции в этом пространстве) k групп. См. « Multiclass LDA » для подробностей ниже.

Линейный дискриминант Фишера

Термины линейный дискриминант Фишера и LDA часто используются как взаимозаменяемые, хотя в оригинальной статье Фишера фактически описывается несколько иной дискриминант, который не делает некоторых допущений LDA, таких как нормально распределенные классы или равные ковариации классов .

Предположим, что два класса наблюдений имеют средние значения и ковариации . Тогда линейная комбинация признаков будет иметь средние и отклонения для . Фишер определил разделение между этими двумя распределениями как отношение дисперсии между классами к дисперсии внутри классов:

Эта мера в некотором смысле является мерой отношения сигнал / шум для маркировки класса. Можно показать, что максимальное разделение происходит, когда

Когда предположения LDA выполняются, приведенное выше уравнение эквивалентно LDA.

Обязательно обратите внимание на то, что вектор является нормальным к дискриминантной гиперплоскости . Например, в двумерной задаче линия, которая лучше всего разделяет две группы, перпендикулярна .

Как правило, точки данных, подлежащие различению, проецируются ; тогда порог, который лучше всего разделяет данные, выбирается из анализа одномерного распределения. Общего правила для порога нет. Однако, если проекции точек из обоих классов демонстрируют примерно одинаковое распределение, хорошим выбором будет гиперплоскость между проекциями двух средних и . В этом случае параметр c в пороговом условии можно найти явно:

- .

Метод Оцу связан с линейным дискриминантом Фишера и был создан для бинаризации гистограммы пикселей в изображении в градациях серого путем оптимального выбора порога черного / белого, который минимизирует внутриклассовую дисперсию и максимизирует межклассовую дисперсию в пределах / между оттенками серого, назначенными черному и черному. классы белых пикселей.

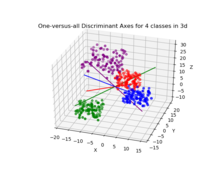

Мультиклассовый LDA

В случае, когда имеется более двух классов, анализ, использованный при выводе дискриминанта Фишера, может быть расширен, чтобы найти подпространство, которое, по-видимому, содержит всю изменчивость класса. Это обобщение принадлежит Ч. Р. Рао . Предположим, что каждый из классов C имеет среднее значение и одинаковую ковариацию . Тогда разброс между изменчивостью классов можно определить с помощью выборочной ковариации средних значений класса.

где - среднее значение класса. Разделение классов по направлению в этом случае будет выражаться следующим образом:

Это означает , что , когда это собственный вектор из разделения будет равен соответствующим собственным значение .

Если диагонализуема, вариативность между функциями будет содержаться в подпространстве, охватываемом собственными векторами, соответствующими C - 1 наибольшим собственным значениям (поскольку имеет ранг C - 1 не более). Эти собственные векторы в основном используются для уменьшения признаков, как в PCA. Собственные векторы, соответствующие меньшим собственным значениям, будут очень чувствительны к точному выбору обучающих данных, и часто необходимо использовать регуляризацию, как описано в следующем разделе.

Если требуется классификация, вместо уменьшения размеров существует ряд альтернативных методов. Например, классы могут быть разделены, и для классификации каждого раздела может использоваться стандартный дискриминант Фишера или LDA. Типичный пример этого - «один против остальных», когда очки одного класса помещаются в одну группу, а все остальное - в другую, а затем применяется LDA. Это приведет к созданию классификаторов C, результаты которых будут объединены. Другой распространенный метод - это попарная классификация, при которой новый классификатор создается для каждой пары классов (всего получается C ( C - 1) / 2 классификатора), при этом отдельные классификаторы объединяются для получения окончательной классификации.

Инкрементальный LDA

Типичная реализация метода LDA требует, чтобы все образцы были доступны заранее. Однако бывают ситуации, когда весь набор данных недоступен, а входные данные наблюдаются как поток. В этом случае желательно, чтобы при извлечении признаков LDA была возможность обновлять вычисленные признаки LDA путем наблюдения за новыми выборками без запуска алгоритма для всего набора данных. Например, во многих приложениях реального времени, таких как мобильная робототехника или онлайн-распознавание лиц, важно обновлять извлеченные функции LDA, как только станут доступны новые наблюдения. Метод извлечения признаков LDA, который может обновлять особенности LDA, просто наблюдая за новыми образцами, представляет собой инкрементный алгоритм LDA , и эта идея широко изучалась в течение последних двух десятилетий. Чаттерджи и Ройчоудхури предложили инкрементный самоорганизующийся алгоритм LDA для обновления функций LDA. В другой работе Демир и Озмехмет предложили онлайн-алгоритмы локального обучения для постепенного обновления функций LDA с использованием исправления ошибок и правил обучения Hebbian. Позже Алияри и др . получены быстрые инкрементные алгоритмы для обновления функций LDA путем наблюдения за новыми образцами.

Практическое использование

На практике классовые средние и ковариации неизвестны. Однако их можно оценить по обучающей выборке. Либо оценка максимального правдоподобия или максимальная апостериорная оценка может быть использована вместо точного значения в приведенных выше уравнениях. Хотя оценки ковариации могут считаться оптимальными в некотором смысле, это не означает, что результирующий дискриминант, полученный путем подстановки этих значений, является оптимальным в любом смысле, даже если предположение о нормально распределенных классах верно.

Другая сложность в применении LDA и дискриминанта Фишера к реальным данным возникает, когда количество измерений каждой выборки (т. Е. Размерность каждого вектора данных) превышает количество выборок в каждом классе. В этом случае оценки ковариации не имеют полного ранга и поэтому не могут быть инвертированы. Есть несколько способов справиться с этим. Один из них - использовать псевдообратную матрицу вместо обычной обратной матрицы в приведенных выше формулах. Однако лучшей числовой стабильности можно достичь, сначала спроецировав проблему на подпространство, охватываемое . Другая стратегия работы с малым размером выборки - использование оценки усадки ковариационной матрицы, которую математически можно выразить как

где - единичная матрица, а - интенсивность усадки или параметр регуляризации . Это приводит к структуре регуляризованного дискриминантного анализа или дискриминантного анализа усадки.

Кроме того, во многих практических случаях линейные дискриминанты не подходят. Дискриминант LDA и Фишера может быть расширен для использования в нелинейной классификации с помощью трюка с ядром . Здесь исходные наблюдения эффективно отображаются в нелинейное пространство более высокой размерности. Тогда линейная классификация в этом нелинейном пространстве эквивалентна нелинейной классификации в исходном пространстве. Наиболее часто используемым примером этого является дискриминант Фишера ядра .

LDA можно обобщить на множественный дискриминантный анализ , где c становится категориальной переменной с N возможными состояниями, а не только с двумя. Аналогично, если условные плотности классов нормальны с общими ковариациями, достаточной статистикой для являются значения N проекций, которые представляют собой подпространство, охватываемое N средними, аффинно проецируемое обратной матрицей ковариации. Эти прогнозы могут быть найдены путем решения обобщенной задачи на собственные значения , где числитель - это ковариационная матрица, сформированная путем обработки средних значений как выборок, а знаменатель - это общая ковариационная матрица. Подробнее см. « Multiclass LDA » выше.

Приложения

В дополнение к примерам, приведенным ниже, LDA применяется в позиционировании и управлении продуктами .

Прогноз банкротства

При прогнозировании банкротства на основе бухгалтерских коэффициентов и других финансовых переменных линейный дискриминантный анализ был первым статистическим методом, применяемым для систематического объяснения того, какие фирмы вступили в банкротство, а какие выжили. Несмотря на ограничения , в то числе известных несоответствий учета коэффициентов для нормальных предположений распределения LDA, Эдвард Альтман «s 1968 модели по - прежнему является ведущей модели в практических приложениях.

Распознавание лица

В компьютеризированном распознавании лиц каждое лицо представлено большим количеством значений пикселей. Здесь в первую очередь используется линейный дискриминантный анализ, чтобы уменьшить количество признаков до более управляемого числа перед классификацией. Каждое из новых измерений представляет собой линейную комбинацию значений пикселей, образующих шаблон. Линейные комбинации, полученные с использованием линейного дискриминанта Фишера, называются гранями Фишера , а комбинации, полученные с помощью соответствующего анализа главных компонент , называются собственными гранями .

Маркетинг

В маркетинге дискриминантный анализ когда-то часто использовался для определения факторов, которые различают разные типы клиентов и / или продуктов на основе опросов или других форм собранных данных. В настоящее время чаще используются логистическая регрессия или другие методы. Использование дискриминантного анализа в маркетинге можно описать следующими этапами:

- Сформулируйте проблему и соберите данные - Определите основные атрибуты, которые потребители используют для оценки продуктов в этой категории. - Используйте методы количественных маркетинговых исследований (например, опросы ) для сбора данных от выборки потенциальных клиентов относительно их оценок всех атрибутов продукта. Стадия сбора данных обычно выполняется профессионалами в области маркетинговых исследований. Вопросы опроса просят респондента оценить продукт от одного до пяти (или от 1 до 7, или от 1 до 10) по ряду атрибутов, выбранных исследователем. Выбирается от пяти до двадцати атрибутов. Они могут включать в себя такие вещи, как простота использования, вес, точность, долговечность, цветность, цена или размер. Выбранные атрибуты будут различаться в зависимости от изучаемого продукта. Тот же вопрос задается обо всех продуктах в исследовании. Данные для нескольких продуктов кодируются и вводятся в статистическую программу, такую как R , SPSS или SAS . (Этот шаг такой же, как и в факторном анализе).

- Оцените коэффициенты дискриминантной функции и определите статистическую значимость и достоверность - выберите соответствующий метод дискриминантного анализа. Прямой метод включает оценку дискриминантной функции, так что все предикторы оцениваются одновременно. Пошаговый метод входит в предикторы последовательно. Метод двух групп следует использовать, когда зависимая переменная имеет две категории или состояния. Метод множественного дискриминанта используется, когда зависимая переменная имеет три или более категориальных состояния. Используйте лямбда Уилкса для проверки значимости в SPSS или F stat в SAS. Наиболее распространенный метод, используемый для проверки достоверности, - это разделение выборки на оценочную или аналитическую выборку и валидационную или контрольную выборку. Оценочная выборка используется при построении дискриминантной функции. Проверочная выборка используется для построения классификационной матрицы, которая содержит количество правильно классифицированных и неправильно классифицированных случаев. Процент правильно классифицированных случаев называется коэффициентом успешности .

- Нанесите результаты на двухмерную карту, определите размеры и интерпретируйте результаты. Статистическая программа (или связанный с ней модуль) отобразит результаты. На карте будет нанесен каждый продукт (обычно в двухмерном пространстве). Расстояние товаров друг от друга показывает, насколько они разные. Размеры должны быть промаркированы исследователем. Это требует субъективного суждения и часто очень сложно. См. Перцепционное отображение .

Биомедицинские исследования

Основное применение дискриминантного анализа в медицине - оценка тяжести состояния пациента и прогноз исхода заболевания. Например, при ретроспективном анализе пациенты делятся на группы по степени тяжести заболевания - легкая, среднетяжелая и тяжелая форма. Затем изучаются результаты клинических и лабораторных анализов с целью выявления статистически различающихся переменных в исследуемых группах. Используя эти переменные, строятся дискриминантные функции, которые помогают объективно классифицировать заболевание будущего пациента на легкую, среднюю или тяжелую форму.

В биологии аналогичные принципы используются для классификации и определения групп различных биологических объектов, например, для определения типов фагов Salmonella enteritidis на основе инфракрасных спектров с преобразованием Фурье, для обнаружения животного источника Escherichia coli, изучения факторов его вирулентности и т. Д.

Наука о планете Земля

Этот метод можно использовать для разделения зон изменения . Например, когда доступны разные данные из разных зон, дискриминантный анализ может найти закономерность в данных и эффективно ее классифицировать.

Сравнение с логистической регрессией

Анализ дискриминантной функции очень похож на логистическую регрессию , и оба могут использоваться для ответа на одни и те же вопросы исследования. Логистическая регрессия не имеет такого количества предположений и ограничений, как дискриминантный анализ. Однако, когда допущения дискриминантного анализа выполняются, он оказывается более действенным, чем логистическая регрессия. В отличие от логистической регрессии, дискриминантный анализ можно использовать с небольшими размерами выборки. Было показано, что когда размеры выборки равны и сохраняется однородность дисперсии / ковариации, дискриминантный анализ более точен. Несмотря на все эти преимущества, логистическая регрессия, тем не менее, стала обычным выбором, поскольку допущения дискриминантного анализа выполняются редко.

Линейный дискриминант в большой размерности

Геометрические аномалии большой размерности приводят к известному проклятию размерности . Тем не менее, правильное использование феномена концентрации меры может облегчить вычисления. Важный случай этого благословения феномена размерности был выделен Донохо и Таннером: если выборка существенно многомерна, то каждая точка может быть отделена от остальной части выборки линейным неравенством с высокой вероятностью даже для экспоненциально больших выборок. Эти линейные неравенства могут быть выбраны в стандартной (фишеровской) форме линейного дискриминанта для богатого семейства вероятностных распределений. В частности, такие теоремы доказываются для логарифмически вогнутых распределений, включая многомерное нормальное распределение (доказательство основано на неравенствах концентрации для логарифмически вогнутых мер) и для мер продукта на многомерном кубе (это доказывается с использованием неравенства концентрации Талагранда для вероятности произведения пробелы). Разделимость данных с помощью классических линейных дискриминантов упрощает проблему исправления ошибок для систем искусственного интеллекта в большой размерности.

Смотрите также

- Сбор данных

- Обучение дереву решений

- Факторный анализ

- Дискриминантный анализ ядра Фишера

- Логит (для логистической регрессии )

- Линейная регрессия

- Множественный дискриминантный анализ

- Многомерное масштабирование

- Распознавание образов

- Регрессия предпочтений

- Квадратичный классификатор

- Статистическая классификация

использованная литература

дальнейшее чтение

- Дуда, РО; Харт, ЧП; Аист, DH (2000). Классификация паттернов (2-е изд.). Wiley Interscience. ISBN 978-0-471-05669-0. Руководство по ремонту 1802993 .

- Хильбе, JM (2009). Модели логистической регрессии . Чепмен и Холл / CRC Press. ISBN 978-1-4200-7575-5.

- Mika, S .; и другие. (1999). «Дискриминантный анализ Фишера с ядрами». Нейронные сети для обработки сигналов IX: Материалы семинара Общества обработки сигналов IEEE 1999 г. (Каталожный номер 98TH8468) . Конференция IEEE по нейронным сетям для обработки сигналов IX . С. 41–48. CiteSeerX 10.1.1.35.9904 . DOI : 10.1109 / NNSP.1999.788121 . ISBN 978-0-7803-5673-3. S2CID 8473401 .

- Макфарланд, Х. Ричард; Дональд, Сент-П. Ричардс (2001). «Вероятности точной неправильной классификации для подключаемых нормальных квадратичных дискриминантных функций. I. Случай равных средних» . Журнал многомерного анализа . 77 (1): 21–53. DOI : 10,1006 / jmva.2000.1924 .

- Макфарланд, Х. Ричард; Дональд, Сент-П. Ричардс (2002). «Вероятности точной неправильной классификации для подключаемых нормальных квадратичных дискриминантных функций. II. Гетерогенный случай» . Журнал многомерного анализа . 82 (2): 299–330. DOI : 10,1006 / jmva.2001.2034 .

- Haghighat, M .; Abdel-Mottaleb, M .; Алхалаби, В. (2016). «Дискриминантный корреляционный анализ: слияние уровней функций в реальном времени для мультимодального биометрического распознавания» . IEEE Transactions по информационной криминалистике и безопасности . 11 (9): 1984–1996. DOI : 10.1109 / TIFS.2016.2569061 . S2CID 15624506 .

внешние ссылки

- Дискриминантный корреляционный анализ (DCA) статьи Haghighat (см. Выше)

- ALGLIB содержит реализацию LDA с открытым исходным кодом на C # / C ++ / Pascal / VBA.

- LDA в Python - реализация LDA в Python

- Учебник LDA с использованием MS Excel

- Биомедицинская статистика. Дискриминантный анализ

- StatQuest: линейный дискриминантный анализ (LDA) четко объяснил на YouTube

- Примечания к курсу, Анализ дискриминантной функции, Дж. Дэвид Гарсон, Университет штата Северная Каролина

- Учебник по дискриминантному анализу в Microsoft Excel от Карди Текномо

- Примечания к курсу, Анализ дискриминантной функции, Дэвид В. Стокбургер, Государственный университет Миссури.

- Анализ дискриминантной функции (DA) Джона Поулсена и Аарона Френча, Государственный университет Сан-Франциско